はじめに:プロジェクトの発端

Runway Gen-3 Alphaが更新されて、画像から動画を生成できるようになったということでした。

それを試そうというのが今回の発端です。

どうせなら夏らしい画像を動かしてみましょうと以下のプロンプトを作る事にしました。

最初のプロンプト

イメージとしては都会の夏らしい風景で、そこに日本人女性が涼しげな服装を着て微笑んでいるという構図。清涼感がある感じ

そんな感じのプロンプトをClaudeに作って貰いました。

それなりに調整してるのでそれっぽいプロンプトを作ってくれます。

1. Stable Diffusionを使ったAI画像生成

私の要求に基づいて、Stable Diffusionのプロンプトを作成してくれて、それを段階的に改善していきました。

初期プロンプト:

vibrant cityscape, summer in Tokyo, crowded street, tall buildings, neon signs, beautiful Japanese woman, elegant sundress, light fabric, gentle smile, refreshing atmosphere, soft evening light, cool breeze, high quality, detailed, photorealisticこのプロンプトから始めて、フィードバックを基に改良を重ねました。プロンプトの改良過程では、より具体的な描写や、不要な要素の除外などを行いました。

最終的なプロンプト:

masterpiece, best quality, (beautiful Japanese woman in her 20s:1.4), mature facial features, confident expression, (elegant summer outfit:1.3), flowing sundress, subtle makeup, (cool sophistication:1.2), (modern Tokyo cityscape:1.4), busy urban plaza, skyscrapers, office buildings, (no traditional buildings:1.2), sunny summer day, young professionals, photorealistic style, medium shot, bright daylight, vibrant urban colorsこのプロンプトは、20代の洗練された日本人女性が、現代的な東京の都市景観を背景に立つ画像を生成します。

こんな感じの画像が出来ました。

2. プロンプト作成のコツ

- 品質、コアプロンプト、追加要素、背景、スタイル、構図、照明の7要素を含める

- 英語で単語ベースのプロンプトを作成

- カンマと半角スペースで単語を区切る

- 重要な要素に重み付け(例:(要素:1.4))を行う

- 否定的な要素を含める(例:no traditional buildings)

- 具体的な形容詞を使用して、より詳細な描写を促す

- 画像の雰囲気や感情を表現する単語を含める

3. 画像の評価と調整

生成された画像を評価し、必要に応じてプロンプトを調整します:

- 背景の混雑感を減らし、清涼感を増加

- 背景の人物の顔の質を向上

- 時間帯を夜から昼に変更

- 伝統的な建物(神社など)を排除し、現代的な都市景観に焦点を当てる

- 女性のイメージを幼い印象から成熟した20代に変更

- 画像の全体的なバランスと構図を確認し、必要に応じて調整

- 色調やコントラストを微調整して、夏の雰囲気を強調

そんな風に修正しながらベースとなる画像を作りました。

モデルも色々と変えて試してみました。

それにより上の画像が完成しました。異なるモデルを試すことで、各モデルの特徴や強みを理解し、目的に最適なモデルを選択することができます。

4. Runway Gen-3 Alphaを使った動画作成

Stable Diffusionで生成した静止画を、Runwayを使って動画に変換します

- Runwayにアカウントを作成し、ログイン

- Gen-3 alphaを選択

- 生成したStable Diffusion画像をアップロード

- サイズが合わない画像の場合トリミング

- 適切なパラメータを設定(設定しなくてもOK)

- 「生成」ボタンをクリックして動画を作成

- 生成された動画を確認し、必要に応じて設定を調整して再生成

相変わらず高価なのは変わらないのでお金には注意です。

100クレジット使いますしね。

そして結構制約厳しいのでセクシー過ぎる女性の画像とか使うと出力してくれませんので注意です。

Runwayのガイドラインに沿った適切な内容の画像を使用することが重要です。

上の画像で出来た映像がこちら。

やたらスピーディーな動きになってしまいました。

変なプロンプト設定したからですね。

クレジットは高くて作り直しできないので一発勝負なのでこのままで。

ただ元画像と比べて殆ど破綻していないのが凄いです。

LumaDreamMachineだとかなり破綻しますからねぇ。

純粋にこちらの方が上だというのがよく分かります。

高いだけあります。

動きの速さは、プロンプトで「slow motion」や「gentle movement」などの指示を追加することで改善できる可能性があります。

2枚目の画像

今度は初音ミク的な画像を作ってみました。

ちょっと現実に寄せてる人物にしています。

リアルに寄せる方がGen-3 Alphaには合うかなと考えたからです。

アニメ系弱いのでは無いかという推測からです。

作成した動画がこちら

これも大きな破綻は無く動画が作れています。

女性の目の色が変わっちゃったり細部が違うという部分はありますけど。

凄くおかしくなったわけじゃないです。

これは優秀ですね。ここまで進化するとは。細部の変化は、AIが動きを生成する際に画像を再解釈しているためと考えられます。

より一貫性のある結果を得るには、プロンプトでキャラクターの特徴をより詳細に指定することが有効かもしれません。

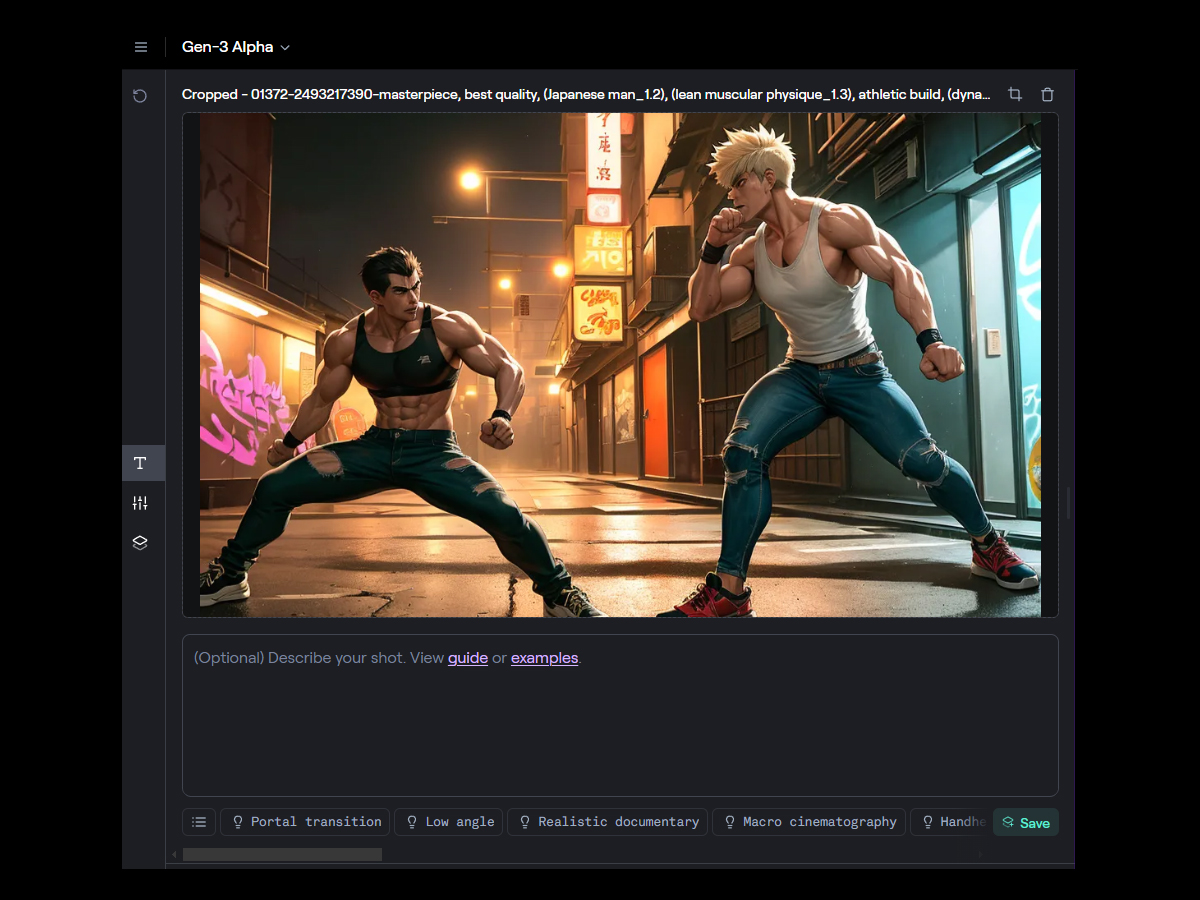

3枚目の画像

今度は、アニメ漫画系の画像でアクションシーンを試しに作ってみます。

こんな感じで男性のストリートファイト的な画像を作りました。

二次元的な感じがあるので悪くない雰囲気だと思います。

これで動画を作ったらどうなるのか!?

唐突にボクシンググローブを付け始めましたけど…。

まぁそれっぽい絵が動いているというのが分かりました。

しっかり画像をトレースしてくれていますね。

AIが「ストリートファイト」を「ボクシング」と解釈した可能性があります。

より正確な動きを得るには、プロンプトで具体的な格闘スタイルを指定するとよいでしょう。

まとめ

AI技術を活用することで静止画から動画まで、創造的なコンテンツを効率的に作成できます。

Stable DiffusionとRunwayの新機能を組み合わせることで、独自の視覚的ストーリーを作り出すことが可能です。

プロンプトの微調整と実験を重ねることで、より質の高い結果を得ることができるでしょう。

LumaDreamMachineとRunway Gen-3 Alphaを比べるとRunway Gen-3 Alphaの方が破綻少ない映像が作れるように感じました。

LumaDreamMachineはもう課金辞めたので分かりませんがちょっと差がついたんじゃ無いだろうかと思いました。

今後の課題としては、より細かいプロンプト制御による動きの調整や、

異なるスタイルの画像での実験が考えられます。

また生成された動画の後処理や編集技術を組み合わせることで、さらに高品質な結果を得られる可能性があります。

AI技術は日々進化しており、今後はさらに高度な画像生成や動画作成が可能になると期待されます。ユーザーとしては、これらのツールの特性を理解し、創造的に活用していくことが重要です。